声明:本文由AIGC生成,部分概念可能不准确,请注意甄别。

本文旨在探讨如何优化 SQLite 数据库中导入几亿条记录的性能,尤其是在数据量达到几千万时性能显著下降的情况。以下内容基于对相关资源和最佳实践的分析,提供了全面的优化策略和注意事项。

背景与问题分析

SQLite 是一种轻量级嵌入式数据库,适合处理大量数据,但当导入数据达到几千万条时,性能可能因以下因素下降:

- 磁盘 I/O:写入大量数据到磁盘可能变慢,尤其在硬盘速度有限或有其他进程竞争时。

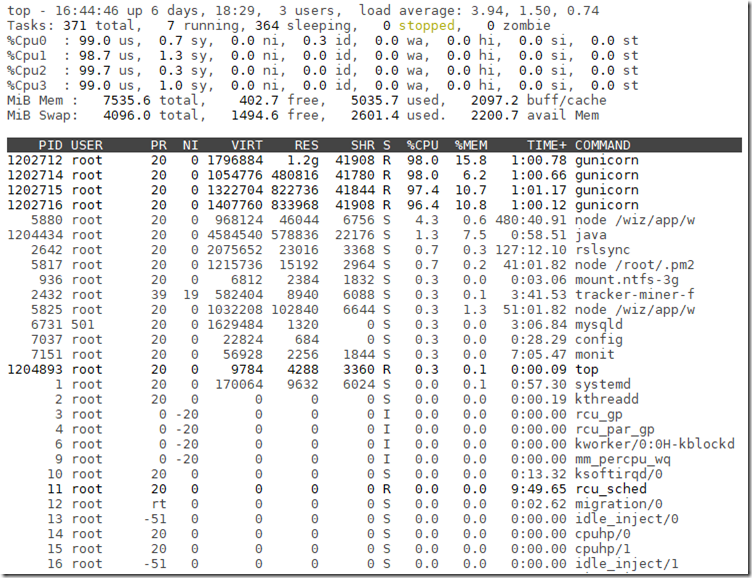

- 内存限制:如果系统内存不足,可能导致交换(swap),显著降低性能。

- 索引维护:如果表上有索引,每次插入都需要更新索引,数据量大时开销增加。

- 事务管理:事务过大可能导致日志文件增长过快,影响性能。

用户已使用事务加速提交,但性能仍不理想,需进一步优化。用户明确表示不需要回滚功能,且使用 SSD,批量参数可调大,使用 GoLang 进行插入操作。

优化策略

1. 使用事务和预编译语句

研究表明,使用事务将多个插入操作分组到一个事务中,可以显著减少提交开销。例如,Improve INSERT-per-second performance of SQLite 提到,单事务插入可将性能从每秒 85 条提升到 23,000 条。此外,使用预编译语句(prepared statements)进一步优化。预编译一次 INSERT 语句,然后为每行绑定值,避免重复编译 SQL。测试显示,这可将性能提升至每秒 53,000 条。在 GoLang 中,虽然预编译语句的使用与批量插入结合效果有限,但通过构造多行 INSERT 语句(如 INSERT INTO table (col1, col2) VALUES (val1, val2), (val3, val4), …;)可以显著提高效率。

2. 批量插入与批量大小优化

批量插入是将多行数据在一次语句中插入,减少事务开销。Fast way to insert rows in SQLite 报告中,一位用户通过每批 100 行插入,成功在 33 秒内插入 1 亿行,约为每秒 3,030,303 行(尽管这一速度可能因硬件和设置而异)。建议实验不同批量大小(如 1000、5000、10000 行),找到系统最佳值。批量过小会导致频繁提交,过大可能耗尽内存。用户提到“批量参数可以调大”,表明他们有能力调整,建议从 1000 开始测试,逐步增加。在 GoLang 中,可以通过构建多行 INSERT 语句实现。例如:go

const batchSize = 1000

for i := 0; i < len(data); i += batchSize {

end := i + batchSize

if end > len(data) {

end = len(data)

}

batch := data[i:end]

var placeholders []string

var params []interface{}

for _, row := range batch {

placeholders = append(placeholders, "(?, ?)")

params = append(params, row.Col1, row.Col2)

}

sqlStr := fmt.Sprintf("INSERT INTO table (col1, col2) VALUES %s", strings.Join(placeholders, ","))

_, err = tx.Exec(sqlStr, params...)

if err != nil {

// handle error

}

}需注意 SQLite 的 SQL 语句长度限制(默认 1,000,000 字节),根据行大小调整批量。

3. 调整 PRAGMA

设置SQLite 的 PRAGMA 设置可显著影响性能,以下是关键选项:

- 同步模式(synchronous):设置 PRAGMA synchronous = OFF 可将性能提升至每秒 69,600 条,但如果操作系统崩溃,可能导致数据损坏。Improve INSERT-per-second performance of SQLite 提供数据对比。

- 日志模式(journal_mode):

- PRAGMA journal_mode = MEMORY:将日志保存在内存,速度快(每秒 64,000 条),但应用崩溃同样有风险。

- PRAGMA journal_mode = OFF:禁用回滚日志,最高速度,但应用崩溃时数据库可能不一致,适合用户“不需回滚”的场景,但风险极高。

- PRAGMA journal_mode = WAL:写前日志模式,安全性较高,且可翻倍插入速度,适合并发场景。SQLite Optimizations for Ultra High-Performance 推荐此模式。

- 缓存大小(cache_size):设置 PRAGMA cache_size = 1000000 可提高事务性能,需根据可用内存调整。

- 锁定模式(locking_mode):设置 PRAGMA locking_mode = EXCLUSIVE 减少锁定开销,适合批量插入。

- 临时存储(temp_store):设置 PRAGMA temp_store = MEMORY 使用内存存储临时表,加速相关操作。

用户使用 SSD,磁盘 I/O 较快,适合上述高风险设置,但需权衡性能与数据完整性。如果是单次导入且能重做,建议使用 synchronous = OFF 和 journal_mode = MEMORY;若需更高安全性,可选择 WAL。

4. 延迟索引创建

如果表上有次要索引,每次插入都需要更新索引,数据量大时开销显著。Improve INSERT-per-second performance of SQLite 提供数据对比:

- 插入前创建索引:每秒 47,700 条。

- 插入后创建索引:每秒 63,300 条。

建议在批量插入前删除次要索引,完成后重建,显著减少插入时开销。用户可根据表结构决定是否适用。

5. 系统资源与 GoLang 特定优化

用户使用 SSD,写入速度较快,适合较大批量大小。GoLang 中,使用 mattn/go-sqlite3 驱动可能存在性能瓶颈(如字符串拷贝开销),但通过多行 INSERT 语句可缓解。Slow performance on bulk insert 提到,驱动在处理大批量语句时可能变慢,建议使用 Exec 方法构造多行 INSERT。确保系统有足够 RAM,避免交换。监控内存使用,调整批量大小以防内存不足。6. 其他注意事项

- 多线程:研究显示,多线程插入未显著改善,可能因 SQLite 单文件锁机制限制。Fast way to insert rows in SQLite 测试结果表明,单线程批量插入已足够快。

- 内存数据库:使用 :memory: 数据库可快速插入(33.08 秒插入 1 亿行),但不适合持久化存储。

- 触发器和约束:检查表是否有触发器或约束,可能拖慢插入。

性能对比表

以下是关键优化技术的性能对比(基于 Improve INSERT-per-second performance of SQLite 和论坛数据):

| 优化技术 | 每秒插入条数 | 备注 |

|---|---|---|

| 单条插入(无优化) | 85 | 使用 sqlite3_exec,性能最差 |

| 使用事务 | 23,000 | 基础优化,减少提交开销 |

| 预编译语句 | 53,000 | 进一步提升,减少 SQL 编译开销 |

| PRAGMA synchronous = OFF | 69,600 | 风险高,OS 崩溃可能损坏数据 |

| PRAGMA journal_mode = MEMORY | 64,000 | 应用崩溃风险高,日志在内存 |

| PRAGMA journal_mode = WAL | ~双倍 | 安全性能平衡,具体数值视场景 |

| 插入后创建索引 | 63,300 | 比插入前创建索引快(47,700),减少实时更新开销 |

| 批量插入(每批 100 行) | ~3,030,303 | 论坛报告,需验证硬件和设置,实际可能低于此 (Fast way to insert rows in SQLite) |

实施建议

- 优先尝试事务、多行 INSERT 语句和 PRAGMA 设置,结合 MEMORY 模式,确保速度提升。

- 如果性能仍不理想,逐步启用风险设置(如 synchronous = OFF),并确保有备份以防崩溃。

- 监控内存和磁盘使用,调整批量大小,避免资源耗尽。

- 测试 JSON1 插入是否适用,若数据源能以 JSON 格式提供,可能显著提升效率,但 GoLang 中需额外处理。

结论

通过上述优化,SQLite 导入几亿条记录的性能可显著提升,尤其在数据量大时。建议用户根据具体场景权衡性能与数据完整性,实验不同设置找到最佳组合。

关键引用

- Improve INSERT-per-second performance of SQLite, detailed optimization techniques

- SQLite Optimizations for Ultra High-Performance, 10 key optimizations

- Towards Inserting One Billion Rows in SQLite Under A Minute, performance benchmarks

- Fast way to insert rows in SQLite, forum discussion on batch inserts

- Slow performance on bulk insert, GoLang driver issue

(4.73分 - 15票)

(4.73分 - 15票)